A l’image d’un poisson rouge, elles t’enferment dans ton bocal. Les « filter bubbles » ou « bulles de filtres » consistent à présenter des contenus ou résultats en fonction de son expérience de navigation en ligne. Leur objectif : créer des conditions optimales pour tailler sur mesure la diffusion de contenus. Ce second volet consacré aux bulles de filtres explore le terrain du journalisme.

Centrée sur l’univers propre à chaque utilisateur, la personnalisation de l’information peut prendre plusieurs formes : la personnalisation par l’exploration, par exemple lorsque l’utilisateur explore une application s’appuyant sur des données ; la personnalisation par l’interaction, par exemple sur le modèle d’un newsgame où le récit est structuré par les choix posé par l’utilisateur après avoir pris connaissance d’une information ; la personnalisation par la curation, par exemple lorsque trois angles sont soumis au choix du lecteur ; et la personnalisation par l’automatisation, par exemple un récit qui va varier en fonction des données de géolocalisation du lecteur. La personnalisation peut également être implicite, inférée à partir des préférences issues des données des utilisateurs ; ou explicite, résultant des réglages de l’utilisateur (Thurman & Schifferes 2012) [1].

Les « pour » et les « contre »

Le procédé peut aider les éditeurs à attirer et fidéliser le public en proposant un contenu ciblé à valeur ajoutée, lequel engagerait davantage les audiences. En opérant une segmentation du public, la personnalisation permet également d’offrir un service à valeur ajoutée (Lavie & alli 2010), lequel peut être monétisé. Elle est aussi un moyen de gérer la surabondance d’informations. Vue sous l’angle des interactions homme-machine, elle promeut l’autonomie de l’utilisateur dans sa volonté non exprimée de s’engager dans une activité ; elle soutient les compétences, en augmentant les actions de l’utilisateur ; et elle maintient le besoin de parenté, caractérisé par la nécessité d’établir des liens émotionnels étroits avec d’autres personnes [2].

Dans le même temps, indique un récent rapport du Nieman Lab, la personnalisation peut créer des bulles de filtres, dont le principal danger réside dans l’enfermement de l’utilisateur dans ses propres croyances et culture. Mais, indique le rapport, la personnalisation est envisagée de manière fondamentalement différente sur le terrain journalistique : « Les organes de presse partagent des informations vraies et, espérons-le, engageantes. Les entreprises technologiques comme Google et Facebook permettent le partage d’informations engageantes et, espérons-le, vraies« .

Aussi, la personnalisation de contenus offrirait-elles des possibilités de faire des nouvelles expériences plus agréables, tout en soulevant des inquiétudes relatives à la perte de connaissances partagées (Lewis & Westlund 2015) [3]. Elle est aussi une stratégie de captation des audiences : fournir un flux personnalisé d’informations est un moyen de réduire la dépendance des utilisateurs envers des fournisseurs externes d’informations (Thurman & Schifferes 2012) [1].

Deux arguments principaux sont essentiellement à charge de la personnalisation d’informations : celui d’un abandon de la mission fondamentale du journalisme, qui consiste à confronter les audiences aux faits ; et celui d’un enfermement culturel préjudiciable à la formation d’opinions citoyennes, isolant l’utilisateur dans ses propres référentiels voire sa seule communauté. « Le souci est que la personnalisation conduit les individus à consommer de plus en plus de la même information. Par conséquent, il est peu probable que les gens consomment des informations qui défient leurs opinions ou contredisent leurs intérêts, ce qui peut comporter des risques pour la formation de l’opinion publique dans une société démocratique » (Graefe & alli 2015) [4]. Le principal défi de l’automatisation serait donc de « de trouver un équilibre entre la création de chambres d’écho et le maintien de la mission de service public du journalisme » (Hansen & alli 2017) [5].

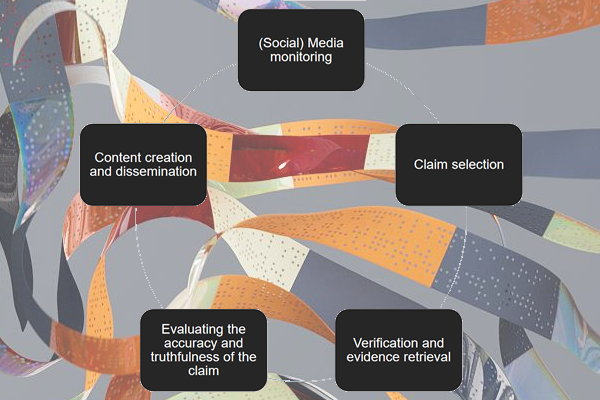

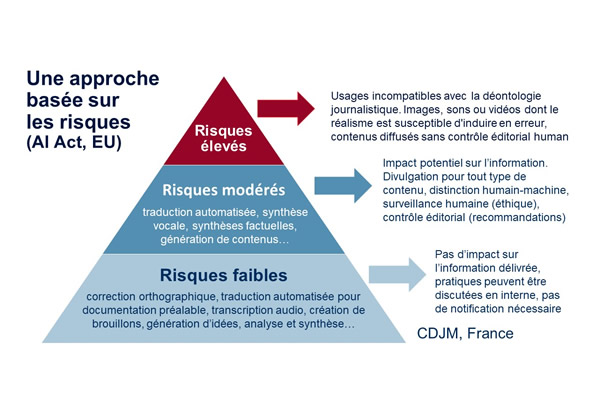

A côté de ces aspects liés à la fonction démocratique de la presse, s’ajoute celui de la mise en œuvre de stratégies s’appuyant sur des procédures informatiques, des algorithmes. Dans la mesure où celles-ci consistent en des choix humains posés en amont, relève d’un processus éditorial : la personnalisation de contenus d’informations consiste donc en une stratégie éditoriale où le filtre n’est pas, en apparence, humain alors que l’une des tâches du journaliste « consiste à suivre, rassembler, organiser et contextualiser informations utiles pour le public cible. Il doit passer par une énorme quantité d’enregistrements contenant des informations de degré de granularité très varié, afin de dans le contexte et raconter son histoire sous tous les angles significatifs, et, en même temps, il doit réduire le bruit du contenu non pertinent » (Tran & Herder 2015) [6].

Filtrage algorithmique

Les algorithmes de personnalisation contrôlent les informations entrantes (l’utilisateur ne voit pas tout), mais déterminent également les informations sortantes et qui seront proposée aux utilisateurs (tout ce qui est partagé par l’utilisateur sera visible) (Bozdag 2013). « La personnalisation et les autres formes de filtrage algorithmique remplacent ainsi les référentiels traditionnels que les individus et les organisations utilisent pour obtenir les informations nécessaires pour résoudre les problèmes et prendre des décisions. Les services qui emploient de tels algorithmes sont des passerelles qui agissent comme intermédiaires entre des sources d’informations et des utilisateurs d’informations », souligne Bozdag [7].

Le filtrage sur lesquels s’appuient les systèmes de personnalisation implique d’inclure ou d’exclure des informations selon diverses règles ou critères. Les applications d’actualité filtrent et trient en fonction de la manière dont elles ont été classées et associée aux intérêts de la personne (Diakopoulos 2015). « Les décisions de filtrage exercent leur pouvoir en exagérant ou en censurant certaines informations. (…) La notion de bulles de filtres repose largement sur l’idée que en n’exposant que les personnes à des informations avec lesquelles elles sont déjà d’accord, cela amplifie les préjugés et entrave le développement des personnes » [8]. Saurwein & alli (2015) soulignent que les services sans personnalisation réduisent les risques de violation de la vie privée, mais présentent moins d’avantages pour les audiences [9]. C’est pourquoi, estiment-ils, ces « produits alternatifs » restent souvent confinés à des services de niche avec un nombre limité d’utilisateurs.

Les mécanismes et finalités de la personnalisation d’informations ne sont pas toujours expliqués ou divulgués (lien : https://digiday.com/media/news-not-netflix-personalizations-appeal-remains-uncertain-publishers/ ), agissant dès lors en toute opacité. « Une histoire a -t-elle été choisie pour sa prééminence statistique ou parce qu’un algorithme de personnalisation l’a choisi pour nous ? Si la sélection était basée sur des statistiques, alors lesquelles – le nombre de mentions de l’histoire, l’autorité des médias qui le promeuvent, ou quelque chose d’autre ? », demande Pasquale (2015) [10].

Il est toutefois opposé que cette transparence n’est pas davantage rencontrée dans les processus journalistiques qui aboutissent à publier telle information, s’appuyant sur telles sources et avec tel angle. Seulement, les journalistes ne sont pas nécessairement associés à la conception de ces systèmes personnalisés qui consistent « en une forme d’individualisation technique qui permet d’interroger des données et de les réassembler comme un ensemble aux caractéristiques différentes » (Fuller & Goffey 2013) [11].

« La personnalisation devrait être un moyen d’améliorer les décisions prises par les rédacteurs humains, les professionnels engagés dans un journalisme de qualité en tant qu’élément essentiel d’une société ouverte.», souligne Powers, citée dans le rapport du Nieman Lab (2017).

La personnalisation pourrait également être considérée comme une solution pour éviter les biais techniques existant dans les services en ligne, mais celle-ci induit de nouveaux biais sans pour autant éliminer tous les autres (Bozdag 2013) [7]. Mais si un biais existe dans les données nourrissant ces procédures, ces biais seront automatiquement répercutés dans le contenu personnalisé.

Infos et services personnalisés

La personnalisation constitue l’une des possibilités de la génération automatique de contenus, en proposant, par exemple, différentes versions d’une même histoire en fonction des publics ou des individus ou en générant des rapports sur une thématique particulière, comme les marchés financiers, pour des clients individuels (Carlson 2015, Graefe 2016) [12] [13]. Elle présente l’avantage de son potentiel d’engagement et de fidélisation des utilisateurs mais, à long terme, la création de bulles de filtres peut devenir dangereuse (Hansen & alli) [5]. Trop de personnalisation, dans les matières politiques notamment, peut transformer le journalisme en instrument de marketing ou de propagande. De plus, « quand tout le monde voit une version différente d’une histoire, il n’y a plus de version faisant autorité » [5].

L’approche par filtrage induite par la personnalisation d’informations suppose que les utilisateurs aient des préférences bien définies. Toutefois, dans le contexte des médias d’information, les intérêts des lecteurs sont complexes et pas toujours conscient. « Un utilisateur qui n’est généralement pas intéressé par le sport peut trouver un intérêt inattendu dans un événement sportif spécifique », soulignent Lavie & alli (2010). Par ailleurs, un utilisateur ne peut pas savoir ce qui pourrait l’intéresser à partir d’informations qui n’ont pas encore été publiées. Ce « pouvoir » induit par le filtrage limite ainsi l’exposition des utilisateurs (Van Den Hoven 2008) [14].

Ces limitations témoignent des limites de la personnalisation et suggèrent que, dans un souci d’adéquation aux usages, les audiences soient associées aux stratégies de personnalisation. « Un système qui personnalise trop profondément (par exemple, il se concentre entièrement sur une équipe de basket-ball spécifique) peut être trop étroite et peut ne pas supporter tous les besoins de l’utilisateur », mettent en garde Lavie et alli [2]. Mais répondre à la demande des utilisateurs ne consiste pas simplement à leur donner « ce qu’ils disent vouloir », cela implique souvent une réponse à des préférences collectées dans le cadre d’actions de surveillance de la part de ces services (Ananny & Crawford 2015) [15].

Dans un rapport prospectif publié par la société suédoise Ericsson, la personnalisation la transformation du journalisme en tant que service. « Le numérique signifie une prise de conscience des besoins individuels et, dans de nombreux cas, une capacité à les résoudre. Mais là aussi, attention à l’intrusion du marketing dans la stratégie éditoriale. Une section de voyage en ligne pourrait recommander d’excellents restaurants dans une ville, aider à faire des réservations, et même choisir une alternative satisfaisante si cet établissement est complet. »

Les chatbots constituent un autre versant de la personnalisation, lesquels consistent à abandonner à des programmes informatiques le soin de la gestion des interactions avec les internautes dans un souci serviciel ou marketing. Contrairement aux « news bots » qui se concentrent sur la curation de contenus, les « chatbots » appartiennent à la catégorie des « social bots » (Grimme & alli 2017) [16]. Ces agents de dialogue sont conçus interagir avec un utilisateur humain en utilisant le langage naturel. Pour autant, ils ne sont pas neufs : ELIZA, conçue en 1964 par Joseph Weizenbaum, était capable de mener des conversations avec des êtres humains, dont certains n’avaient pas eu le sentiment d’avoir dialogué avec une machine (Bouillon, 1998) [17].

En Belgique francophone, IPM est le premier groupe de presse à avoir lancé un chatbot, en avril 2017, accessible via la plateforme Facebook Messenger. Pour le groupe, il ne s’agit pas uniquement d’un « gadget technologique de plus comme on pourrait le croire. Il permet d’augmenter l’offre d’information à disposition des utilisateurs. En effet, un menu automatique vous propose le choix entre différentes catégories d’informations et vous propose donc uniquement l’information qui vous intéresse. Il vous permet également de rechercher des infos via des mots-clés liés à l’actualité ». Denis Pierrard, directeur général du groupe, indique qu’une raison de ce développement s’inscrit dans « l’ère de la personnalisation de l’info » où le média « doit entretenir une relation one-to-one avec ses lecteurs » en s’adaptant aux nouveautés ainsi que pour « combattre le problème des fake news ».

Images : CanStockPhotos

+ Lire le long format : Les algorithmes dans l’information

Références

[1] Thurman, N., & Schifferes, S. (2012). The future of personalization at news websites: lessons from a longitudinal study. Journalism Studies, 13(5-6), 775-790.

[2] Lavie, T., Sela, M., Oppenheim, I., Inbar, O., & Meyer, J. (2010). User attitudes towards news content personalization. International journal of human-computer studies, 68(8), 483-495.

[3] Lewis, S. C., & Westlund, O. (2015). Actors, actants, audiences, and activities in cross-media news work: A matrix and a research agenda. Digital Journalism, 3(1), 19-37.

[4] Graefe, A., Haim, M., Haarmann, B., & Brosius, H. B. (2015). Perception of automated computer-generated news: credibility, expertise, and readability. 11th Dubrovnik Media Days, Dubrovnik.

[5] Hansen, M., Roca-Sales, M., Keegan, J. M., & King, G. (2017). Artificial Intelligence: Practice and Implications for Journalism.

[6] Tran, G. B., & Herder, E. (2015, June). Detecting Filter Bubbles in Ongoing News Stories. In UMAP Workshops.

[7] Bozdag, E. (2013). Bias in algorithmic filtering and personalization. Ethics and information technology, 15(3), 209-227.

[8] Diakopoulos, N. (2015). Algorithmic accountability: Journalistic investigation of computational power structures. Digital Journalism, 3(3), 398-415.

[9] Saurwein, F., Just, N., & Latzer, M. (2015). Governance of algorithms: options and limitations. Info, 17(6), 35-49.

[10] Pasquale, F. (2015). The black box society: The secret algorithms that control money and information. Harvard University Press.

[11] Fuller, M., & Goffey, A. (2012). Evil media. MIT Press.

[12] Carlson, M. (2015). The robotic reporter: Automated journalism and the redefinition of labor, compositional forms, and journalistic authority. Digital Journalism, 3(3), 416-431.

[13] Graefe, A. (2016). Guide to automated journalism. Tow Center for Digital Journalism. https://towcenter.org/research/guide-to-automated-journalism/

[14] Van Den Hoven, J., & Weckert, J. (Eds.). (2008). Information technology and moral philosophy. Cambridge University Press.

[15] Ananny, M., & Crawford, K. (2015). A Liminal Press: Situating news app designers within a field of networked news production. Digital Journalism, 3(2), 192-208.

[16] Grimme, C., Preuss, M., Adam, L., & Trautmann, H. (2017). Social Bots: Human-Like by Means of Human Control?. arXiv preprint arXiv:1706.07624.

[17] Bouillon, P. (1998). Traitement automatique des langues naturelles. De Boeck Supérieur.